一、平均负载是什么

平均负载是指单位时间内,系统处于可运行状态和不可中断状态的平均进程数,也就是平均活跃进程数,它和 CPU 使用率并没有直接关系。

可运行状态的进程:指正在使用 CPU 或者正在等待 CPU 的进程,也就是我们常用 ps 命令看到的,处于 R 状态(Running 或 Runnable)的进程。

不可中断状态的进程:指正处于内核态关键流程中的进程,并且这些流程是不可打断的,比如最常见的是等待硬件设备的 I/O 响应,也就是我们在 ps 命令中看到的 D 状态(Uninterruptible Sleep,也称为 Disk Sleep)的进程。比如,当一个进程向磁盘读写数据时,为了保证数据的一致性,在得到磁盘回复前,它是不能被其他进程或者中断打断的,这个时候的进程就处于不可中断状态。如果此时的进程被打断了,就容易出现磁盘数据与进程数据不一致的问题。所以,不可中断状态实际上是系统对进程和硬件设备的一种保护机制。

因此,你可以简单理解为,平均负载其实就是平均活跃进程数。平均活跃进程数,直观上的理解就是单位时间内的活跃进程数,但它实际上是活跃进程数的指数衰减平均值。这个“指数衰减平均”的详细含义你不用计较,这只是系统的一种更快速的计算方式,你把它直接当成活跃进程数的平均值也没问题。

既然平均的是活跃进程数,那么最理想的,就是每个 CPU 上都刚好运行着一个进程,这样每个 CPU 都得到了充分利用。比如当平均负载为 2 时,意味着什么呢?

在只有 2 个 CPU 的系统上,意味着所有的 CPU 都刚好被完全占用。

在 4 个 CPU 的系统上,意味着 CPU 有 50% 的空闲。

而在只有 1 个 CPU 的系统中,则意味着有一半的进程竞争不到 CPU。

二、平均负载为多少时合理

我们知道,平均负载最理想的情况是等于 CPU 个数。所以在评判平均负载时,首先你要知道系统有几个 CPU,这可以通过 top 命令或者从文件 /proc/cpuinfo 中读取,比如:

$ grep 'model name' /proc/cpuinfo | wc -l有了 CPU 个数,我们就可以判断出,当平均负载比 CPU 个数还大的时候,系统已经出现了过载。

说到这个,就不得不提及常用查询系统负载命令

$ uptime

01:35:59 up 1:09, 1 user, load average: 0.00, 0.00, 0.00从上可以看出平均负载有三个值,三个值分别对应了 1 分钟、5 分钟、15 分钟的平均负载。

如果 1 分钟、5 分钟、15 分钟的三个值基本相同,或者相差不大,那就说明系统负载很平稳。但如果 1 分钟的值远小于 15 分钟的值,就说明系统最近 1 分钟的负载在减少,而过去 15 分钟内却有很大的负载。反过来,如果 1 分钟的值远大于 15 分钟的值,就说明最近 1 分钟的负载在增加,这种增加有可能只是临时性的,也有可能还会持续增加下去,所以就需要持续观察。一旦 1 分钟的平均负载接近或超过了 CPU 的个数,就意味着系统正在发生过载的问题,这时就得分析调查是哪里导致的问题,并要想办法优化了。

在实际生产环境中,平均负载多高时,需要我们重点关注呢?

一般情况下,当平均负载高于 CPU 数量 70% 的时候,你就应该分析排查负载高的问题了。一旦负载过高,就可能导致进程响应变慢,进而影响服务的正常功能。

三、平均负载与 CPU 使用率

平均负载是指单位时间内,处于可运行状态和不可中断状态的进程数。所以,它不仅包括了正在使用 CPU 的进程,还包括等待 CPU 和等待 I/O 的进程。

而 CPU 使用率,是单位时间内 CPU 繁忙情况的统计,跟平均负载并不一定完全对应,例如:

CPU 密集型进程,使用大量 CPU 会导致平均负载升高,此时这两者是一致的;

I/O 密集型进程,等待 I/O 也会导致平均负载升高,但 CPU 使用率不一定很高;

大量等待 CPU 的进程调度也会导致平均负载升高,此时的 CPU 使用率也会比较高。

四、案例分析

1)工具准备

stress:stress 是一个 Linux 系统压力测试工具,这里我们用作异常进程模拟平均负载升高的场景。

sysstat:包含了常用的 Linux 性能工具,用来监控和分析系统的性能。常用的有以下两个命令 mpstat 和 pidstat。

mpstat:是一个常用的多核 CPU 性能分析工具,用来实时查看每个 CPU 的性能指标,以及所有 CPU 的平均指标。

pidstat:是一个常用的进程性能分析工具,用来实时查看进程的 CPU、内存、I/O 以及上下文切换等性能指标。

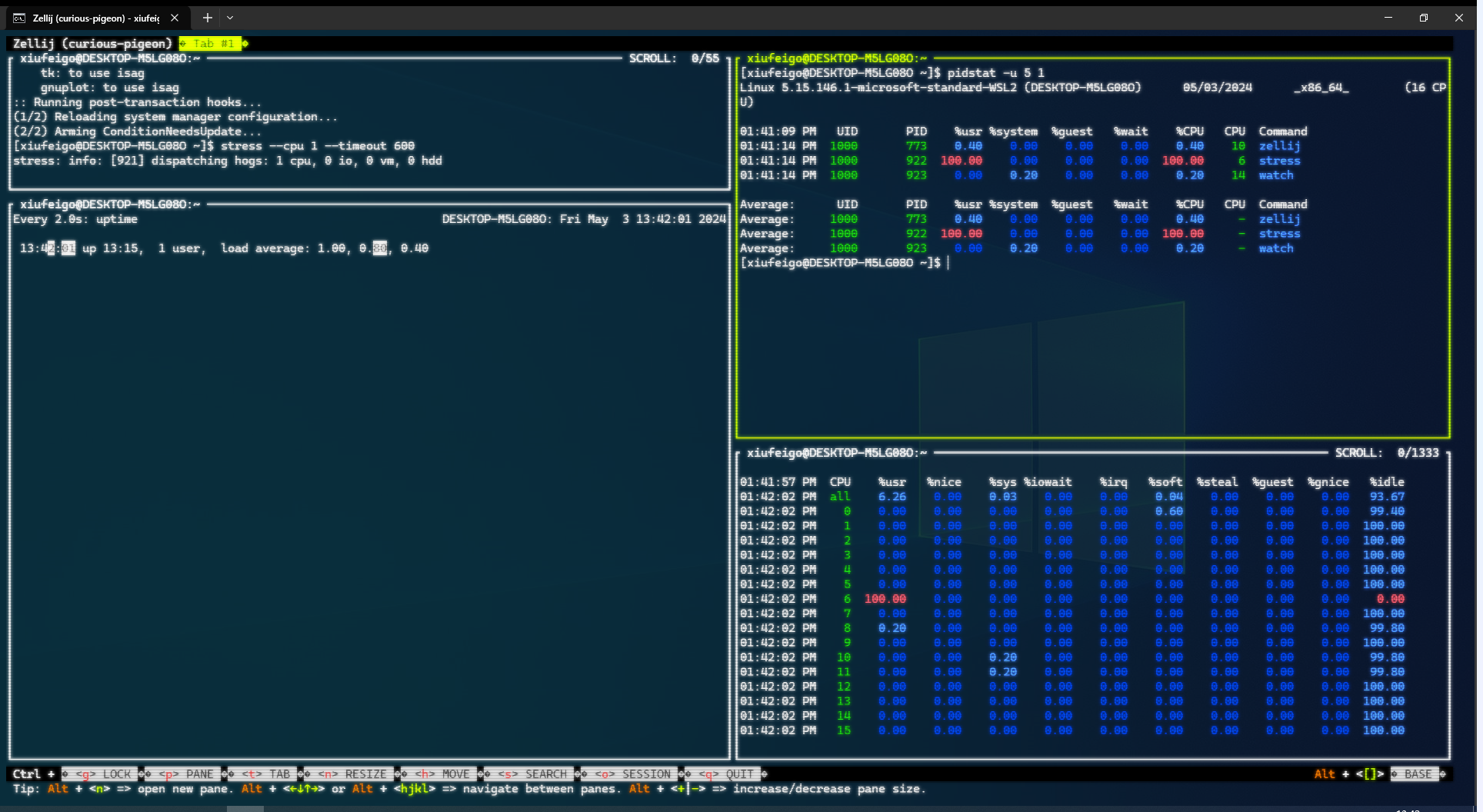

2)场景一:CPU 密集型进程

先在一个终端运行 stress 命令,模拟一个 CPU 使用率 100% 的场景:

$ stress --cpu 1 --timeout 600在另一个终端执行 uptime 查看平均负载的变化情况:

# -d 参数表示高亮显示变化的区域

$ watch -d uptime

Every 2.0s: uptime DESKTOP-M5LG08O: Fri May 3 13:34:55 2024

13:37:29 up 13:11, 1 user, load average: 0.95, 0.47, 0.18在最后一个终端运行 mpstat 查看 CPU 使用率的变化情况:

# -P ALL 表示监控所有CPU,后面数字5表示间隔5秒后输出一组数据

$ mpstat -P ALL 5

01:36:12 PM CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

01:36:17 PM all 6.26 0.00 0.01 0.00 0.00 0.00 0.00 0.00 0.00 93.72

01:36:17 PM 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 2 0.20 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 99.80

01:36:17 PM 3 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 4 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 5 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 6 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

01:36:17 PM 7 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 8 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 9 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 10 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 11 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 12 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 13 0.00 0.00 0.20 0.00 0.00 0.00 0.00 0.00 0.00 99.80

01:36:17 PM 14 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

01:36:17 PM 15 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

从终端二中可以看到,1 分钟的平均负载会慢慢增加到 0.95,而从终端三中还可以看到,正好有一个 CPU 的使用率为 100%,但它的 iowait 只有 0。这说明,平均负载的升高正是由于 CPU 使用率为 100% 。要找出是哪个进程导致了 CPU 使用率为 100% 可以使用 pidstat 来查询:

# 间隔 5 秒后输出一组数据

$ pidstat -u 5 1

01:41:09 PM UID PID %usr %system %guest %wait %CPU CPU Command

01:41:14 PM 1000 773 0.40 0.00 0.00 0.00 0.40 10 zellij

01:41:14 PM 1000 922 100.00 0.00 0.00 0.00 100.00 6 stress

01:41:14 PM 1000 923 0.00 0.20 0.00 0.00 0.20 14 watch这里可以明显看到,stress 进程的 CPU 使用率为 100%。

3)I/O 密集型进程

首先还是运行 stress 命令,但这次模拟 I/O 压力,即不停地执行 sync:

$ stress -i 1 --timeout 600还是在第二个终端运行 uptime 查看平均负载的变化情况:

$ watch -d uptime

14:01:09 up 13:34, 1 user, load average: 0.77, 0.40, 0.30第三个终端运行 mpstat 查看 CPU 使用率的变化情况:

# 显示所有CPU的指标,并在间隔 5 秒输出一组数据

$ mpstat -P ALL 5 1

Average: CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

Average: all 0.03 0.00 1.32 3.59 0.00 0.11 0.00 0.00 0.00 94.95

Average: 0 0.20 0.00 0.00 0.00 0.00 0.81 0.00 0.00 0.00 98.98

Average: 1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 2 0.00 0.00 8.89 36.16 0.00 0.00 0.00 0.00 0.00 54.95

Average: 3 0.00 0.00 5.80 22.15 0.00 1.04 0.00 0.00 0.00 71.01

Average: 4 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 5 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 6 0.00 0.00 6.49 0.00 0.00 0.00 0.00 0.00 0.00 93.51

Average: 7 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 8 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 9 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 10 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 11 0.00 0.00 0.20 0.00 0.00 0.00 0.00 0.00 0.00 99.80

Average: 12 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 13 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

Average: 14 0.20 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 99.80

Average: 15 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100.00

从这里可以看到,1 分钟的平均负载会慢慢增加到 0.77,其中一个 CPU 的系统 CPU 使用率升高到了 0.2(手动狗头),而 iowait 高达 36.16%。这说明,平均负载的升高是由于 iowait 的升高。我们还是通过 pidstat 来查询是哪个进程导致的 iowait 升高

# 间隔 5 秒后输出一组数据,-u 表示 CPU 指标

$ pidstat -u 5 1

02:04:31 PM UID PID %usr %system %guest %wait %CPU CPU Command

02:04:36 PM 1000 773 0.60 0.20 0.00 0.00 0.80 8 zellij

02:04:36 PM 1000 2771 0.20 12.00 0.00 0.00 12.20 3 stress可以发现,还是 stress 进程导致的。

4)大量进程场景

当系统中运行进程超出 CPU 运行能力时,就会出现等待 CPU 的进程。

我们还是使用 stress,但这次模拟的是 32 个进程:

$ stress -c 64 --timeout 600由于系统只有 16 个 CPU,明显比 64 个进程要少得多,因而,系统的 CPU 处于严重过载状态,平均负载高达 7.97:

$ watch -d uptime

14:09:27 up 13:43, 1 user, load average: 36.36, 10.30, 3.75老规矩,mpstat 看下 CPU 使用率的变化情况:

# 显示所有CPU的指标,并在间隔 5 秒输出一组数据

$ mpstat -P ALL 5 1

Average: CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

Average: all 99.83 0.00 0.15 0.00 0.00 0.03 0.00 0.00 0.00 0.00

Average: 0 99.50 0.00 0.10 0.00 0.00 0.40 0.00 0.00 0.00 0.00

Average: 1 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 2 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 3 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 4 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 5 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 6 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 7 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 8 99.10 0.00 0.90 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 9 99.80 0.00 0.20 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 10 99.40 0.00 0.60 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 11 99.50 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 12 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 13 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 14 99.90 0.00 0.10 0.00 0.00 0.00 0.00 0.00 0.00 0.00

Average: 15 100.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00接着再运行 pidstat 来看一下进程的情况,可以看出,64 个进程在争抢 16 个 CPU,每个进程等待 CPU 的时间(也就是代码块中的 %wait 列)高达 75%。这些超出 CPU 计算能力的进程,最终导致 CPU 过载。:

# 间隔 5 秒后输出一组数据

$ pidstat -u 5 1

Average: UID PID %usr %system %guest %wait %CPU CPU Command

Average: 1000 773 0.79 0.00 0.00 0.00 0.79 - zellij

Average: 1000 3369 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3370 24.75 0.00 0.00 74.06 24.75 - stress

Average: 1000 3371 24.55 0.20 0.00 74.46 24.75 - stress

Average: 1000 3372 24.95 0.00 0.00 74.06 24.95 - stress

Average: 1000 3373 24.75 0.00 0.00 74.65 24.75 - stress

Average: 1000 3374 24.55 0.00 0.00 74.85 24.55 - stress

Average: 1000 3375 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3376 24.55 0.00 0.00 74.85 24.55 - stress

Average: 1000 3377 24.75 0.00 0.00 74.06 24.75 - stress

Average: 1000 3378 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3379 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3380 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3381 24.75 0.00 0.00 74.06 24.75 - stress

Average: 1000 3382 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3383 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3384 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3385 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3386 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3387 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3388 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3389 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3390 24.95 0.00 0.00 73.86 24.95 - stress

Average: 1000 3391 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3392 24.55 0.00 0.00 74.06 24.55 - stress

Average: 1000 3393 24.95 0.00 0.00 73.86 24.95 - stress

Average: 1000 3394 24.95 0.00 0.00 73.86 24.95 - stress

Average: 1000 3395 24.75 0.00 0.00 74.65 24.75 - stress

Average: 1000 3396 24.55 0.00 0.00 74.65 24.55 - stress

Average: 1000 3397 24.55 0.00 0.00 74.06 24.55 - stress

Average: 1000 3398 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3399 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3400 24.55 0.00 0.00 74.06 24.55 - stress

Average: 1000 3401 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3402 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3403 24.55 0.00 0.00 74.06 24.55 - stress

Average: 1000 3404 24.55 0.00 0.00 74.65 24.55 - stress

Average: 1000 3405 24.95 0.00 0.00 74.06 24.95 - stress

Average: 1000 3406 24.75 0.00 0.00 74.65 24.75 - stress

Average: 1000 3407 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3408 24.75 0.00 0.00 74.06 24.75 - stress

Average: 1000 3409 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3410 24.95 0.00 0.00 74.26 24.95 - stress

Average: 1000 3411 24.95 0.00 0.00 74.06 24.95 - stress

Average: 1000 3412 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3413 24.75 0.00 0.00 74.06 24.75 - stress

Average: 1000 3414 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3415 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3416 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3417 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3418 24.75 0.00 0.00 73.86 24.75 - stress

Average: 1000 3419 24.75 0.00 0.00 74.65 24.75 - stress

Average: 1000 3420 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3421 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3422 24.95 0.00 0.00 74.26 24.95 - stress

Average: 1000 3423 24.95 0.00 0.00 74.65 24.95 - stress

Average: 1000 3424 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3425 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3426 24.75 0.00 0.00 74.26 24.75 - stress

Average: 1000 3427 24.75 0.00 0.00 73.86 24.75 - stress

Average: 1000 3428 24.55 0.00 0.00 74.46 24.55 - stress

Average: 1000 3429 24.95 0.00 0.00 74.06 24.95 - stress

Average: 1000 3430 24.75 0.00 0.00 74.46 24.75 - stress

Average: 1000 3431 24.75 0.00 0.00 74.85 24.75 - stress

Average: 1000 3432 24.75 0.00 0.00 73.86 24.75 - stress

五、小结

平均负载提供了一个快速查看系统整体性能的手段,反映了整体的负载情况。但只看平均负载本身,我们并不能直接发现,到底是哪里出现了瓶颈。所以,在理解平均负载时,也要注意以下几个点:

平均负载高有可能是 CPU 密集型进程导致的;

平均负载高并不一定代表 CPU 使用率高,还有可能是 I/O 更繁忙了;

当发现负载高的时候,你可以使用 mpstat、pidstat 等工具,辅助分析负载的来源。

排查思路:uptime → mpstat → pidstat